الذكاء الاصطناعي وأثره في حياتنا اليومية

اتّسع دور الذّكاء الاصطناعيّ (AI) في القرن 21، وامتدّ ليشمل العديد من جوانب حياتنا اليوميّة، وذلك نظرًا للتّطوّر السّريع في تطبيقاته.

فباستخدام الذكاء الاصطناعي تمكن تأدية أعمالٍ شاقّةٍ أو خطيرةٍ أو مملّةٍ، بالإضافة إلى إمكان إدارة أنظمة الذّكاء الاصطناعيّ للمهامّ المعقّدة وكثيفة البيانات. ومع ذلك، فإنّ من الصّعب الإجماع بشأن التّأثير المجتمعيّ للذّكاء الاصطناعيّ، حيث يتوقّع الكثيرون أن يتسبّب في تأثيراتٍ أكثر خطورةً من الثّورات التّكنولوجيّة السّابقة.[1]

وبالرّغم من أنّ الذكاء الاصطناعي يُعدّ نظامًا واعدًا في محاكاة الذّكاء البشريّ، للقيام بالمهامّ المتعلّقة بالتّفكير والتّعلّم وحلّ المشكلات بالإضافة إلى اتّخاذ القرارات، وهو ما ظهر جليًّا من خلال الرّوبوتات وأجهزة الكمبيوتر؛ إلّا إنّ تقنيّاته وتطبيقاته ما زالت قيد البحث والتّطوير لضمان أداء مهامّها دون ارتكاب أخطاءٍ وبعيدًا عن السّيطرة أو المساعدة البشريّة.[4]

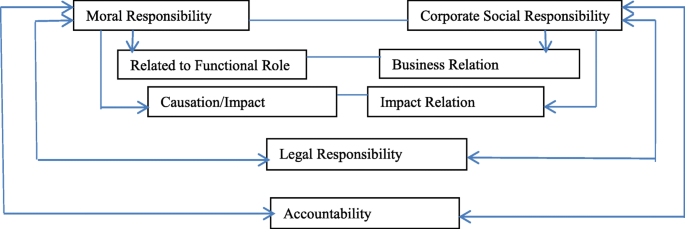

فمثلًا، على من يقع اللّوم في حال تضرّر أحد المشاة من سيّارةٍ ذاتيّة القيادة؟ وما هي حدود مسؤوليّة الأطراف المختلفة المشاركة في صناعة وتشغيل هذه السّيّارة المعتمدة على الذكاء الاصطناعي؛ مثل جهة تصنيع السّيّارة، ومالك السّيّارة، والسّلطة المختصّة بالطّرق، فضلًا عن مدى مسؤوليّة السّيّارة نفسها؛ كونها تتعلّم ذاتيًّا وتتّخذ القرارات؟[1]

ما هو الذكاء الاصطناعي؟

الفرق بين الأنظمة المؤتمتة (Automated Systems) والأنظمة الذاتيّة (Autonomous Systems)

هنا عزيزي القارئ، نحتاج أن نتمهّل قليلًا لنفهم الفرق بين الأنظمة المؤتمتة (Automated Systems) والأنظمة الذّاتيّة (Autonomous Systems) لنصل لأقرب مفهومٍ عن الذكاء الاصطناعي.[2]

الأنظمة المؤتمتة: هي الأنظمة الّتي يُغذّى فيها الكمبيوتر بسلسلةٍ متعاقبةٍ من الأوامر الشّرطيّة (if–then–else) لأداء مهامّ محدّدةٍ. وبالتّالي تعطي نفس المخرجات لمدخلاتٍ محدّدةٍ مهما تكرّر الأمر. أي أنّ النّظام يعطي نفس النّتيجة لنفس المعطيات إلّا في حال حدوث خطأٍ في النّظام.[2]

وعلى الجانب الآخر، الأنظمة الذّاتيّة: هي الأنظمة القادرة على استكشاف أفضل الطّرق لتنفيذ المهامّ المطلوبة. وبالتّالي فإنّ مخرجات هذه الأنظمة لا يلزم أن تكون متطابقةً عند تكرار المعطيات، وإنّما يتراوح سلوكها بين مجموعةٍ من السّلوكيّات المحتملة تبعًا لتخمينها لأفضل مسارٍ.[2]

ومن المعلوم أنّ الذّكاء البشريّ يتبع سياقًا يُعرف باسم حلقة «الحسّ-الإدراك-الفعل» لمعالجة المعلومات (The perception–cognition–action information processing loop)، حيث يستقبل الشّخص من خلال حواسّه معلوماتٍ عن العالم حوله، فيفكّر فيما يجب تنفيذه من الخيارات المطروحة بناءً على تقييم هذه الخيارات؛ ثمّ يتّخذ الشّخص قراره وينفّذه.

وعليه فبرمجة الذّكاء الاصطناعيّ تنفّذ سياقًا مشابهًا لما سبق، حيث يستشعر الكمبيوتر المعطيات من حوله، ثمّ يعالجها بواسطة خوارزميّات التّحسين والتّحقّق، لاختيار الإجراء الأفضل.[2]

ويمكننا هنا تعريف الذّكاء الاصطناعيّ بأنّه: قدرة النّظام على التّرجمة والتّعلّم من البيانات الخارجيّة بشكلٍ صحيحٍ، لتحقيق أهدافٍ ومهامّ محدّدةٍ بمرونةٍ.[3]

الذكاء الاصطناعي المسؤول

الهدف من أنظمة الذكاء الاصطناعي تسهيل حياة الإنسان. وبالرّغم من ذلك، يوجد جدلٌ كبيرٌ حول مزاياه وعيوبه. فمن جانبٍ، التّطبيق النّاجح لأنظمة الذّكاء الاصطناعيّ سيساعد في زيادة الرّبحيّة والابتكاريّة. ولكن على الجانب الآخر فإنّ تنامي ذكاء هذه الأنظمة يغذّي احتماليّة أن تكتسب ذكاءً يساوي أو يتخطّى ذكاء البشر. ممّا يثير القلق بشأن ما سينجم عن ذلك من تغيّراتٍ اجتماعيّةٍ وسياسيّةٍ. فعلى سبيل المثال، قد يقرّر الذّكاء الاصطناعيّ استعمار العالم دون مساعدة البشر، وحينها ستكون موازين القوى في صالحه.[4]

لذلك، يُعتبر الذّكاء الاصطناعيّ المسؤول (Responsible AI) لبنةً أساسيّةً لتحديد شكل التّعامل مع المجتمع البشريّ، فمن الضّروريّ تصميم أنظمة الذّكاء الاصطناعيّ لتكون متّسقةً مع القيم الإنسانيّة. فاللّوائح الّتي ستوضع لأنظمة الذّكاء الاصطناعيّ لا بدَّ أن تؤسّس لآليّاتٍ تمكّن هذه الأنظمة بذاتها من التّفكير والتّصرّف بطريقةٍ أخلاقيّةٍ وفقًا للقيم الإنسانيّة دون التّدخّل البشريّ. وهذا يتطلّب وضع لوائح للقواعد والسّلوك، وكذلك بذل الجهد في تحديث قطاعات التّعليم والتّدريب لمواكبة التّغييرات المنتظرة بالوعي المطلوب.[1]

هل هذا كلّ شيءٍ؟ بالتّأكيد لا. إنّ تصميم أنظمة الذّكاء الاصطناعيّ الّتي تراعي في تطبيقها المبادئ الأخلاقيّة والقيم الإنسانيّة، هو أكثر من مجرّد تطويرٍ لبعض الميزات الإضافيّة. وإنّما توجد العديد من العوامل الّتي يجب على المجتمع البشريّ -حكوماتٍ ومواطنين- أن يقوم بتحديدها لتشريع وتنظيم دور الذّكاء الاصطناعيّ المسؤول في المجتمع، استنادًا على ثلاث ركائز أساسيّةٍ:[1]

أوّلًا: وعي المجتمع بتأثير أنظمة الذكاء الاصطناعي والاستعداد لتحمّل مسؤوليّة تطبيقها. ممّا يضع على كاهل الباحثين والمطوّرين مسؤوليّة تصميم هذه الأنظمة بحيث تتميّز باستقلاليّتها وتفاعلها وقدرتها على التّكيّف. حيث تتكامل مسؤوليّتهم مع مسؤوليّة باقي المجتمع فى كيفيّة استقبال هذه الأنظمة بشكلٍ إيجابيٍّ.

ثانيًا: الحاجة إلى نماذج وخوارزميّاتٍ لتمكين هذه الأنظمة من اتّخاذ قراراتٍ تراعي القيم الإنسانيّة، وتستطيع تبرير هذه القرارات بناءً على تلك القيم. حيث إنّ آليّات التّعلّم العميق (Deep Learning) مازالت غير قادرةٍ على ربط المخرجات بالمدخلات بشكلٍ منطقيٍّ، وبالتّالي لا يمكن تفسيرها بالمفاهيم البشريّة.

ثالثًا: من أجل تطوير أطر تفاعل البشر مع هذه الأنظمة وتحسين قدرتهم على التّعايش معها وذلك لمختلف الثّقافات، يكون من الضّروريّ عدم اعتبار تقنيّات الذّكاء الاصطناعيّ أنظمةً مستقلّةً. وإنّما تجب دراسة هذه التّقنيّات كجزءٍ من العلاقات الاجتماعيّة والتّقنيّة. وهنا يلعب التّعليم -كأحد القطاعات المهمّة لتطوّر وتقدّم المجتمعات- دورًا مهمًّا، لتوعية النّاس بإمكانيّة مشاركتهم في نشر المعرفة بالذّكاء الاصطناعيّ وتشكيل التّنمية المجتمعيّة.[1]

وختامًا، لضمان أنّ تطوير خوارزميّات الذّكاء الاصطناعيّ يهدف إلى تحسين الأداء وتقدّم البشريّة، فإنّ تصميم هذه الأنظمة لا بدَّ أن يهتمّ بإعطائها القدرة على التّعلّم ومراعاة مبادئ المساءلة والمسؤوليّة والشّفافيّة بطريقةٍ واضحةٍ ومنهجيّةٍ. وهذا يستلزم تغييرًا في عقليّة الباحثين والمطوّرين لتوجيهها نحو الاهتمام بتحسين الشّفافيّة تماشيًا مع الأداء، للوصول إلى تقنيّاتٍ وتطبيقاتٍ مبتكرةٍ تسهّل نواحي الحياة دون المساس بالقيم الإنسانيّة.[1]